Restrisiko

Anmerkungen zum künstlichen Gewissen

Veröffentlicht in: Antje Bultmann, Hans-Jürgen Fischbeck (Hg.), Gewissenlose Geschäfte. Wie Wirtschaft und Industrie unser Leben aufs Spiel setzen, München 1996. Anmerkung von Peter Kafka: „Dies ist eine mehrfach übermalte Kollage aus verschiedenen Texten der letzten 15 Jahre (1). Beim Versuch, den schon früher unausweichlichen Sarkasmus zu dämpfen, hat sich dieser noch verstärkt, weil die Untergangssymptome immer deutlicher, die Reaktionen darauf aber oft noch absurder geworden sind. Doch Sarkasmus ist ein Zeichen von Hoffnung“.

Zum Ausdrucken: PDF

Annäherung an den Risikobegriff

Erinnert sich noch jemand an die Katastrophe beim Flugtag 1988 in Ramstein, als zwei Jagdflugzeuge sich berührten und in die Zuschauermassen stürzten? An die hundert Menschen starben sofort oder nach wochenlangem Todeskampf, und wohl noch mehr wurden für den Rest ihres Lebens entstellt. Viele meinten damals, solche Veranstaltungen dürften nicht mehr zugelassen werden. Der damalige Präsident des Deutschen Aero-Clubs und frühere Chef der Lufthansa, Herbert Culmann, aber begriff sofort, wie kleinmütig ein solches Verbot gewesen wäre. »Das Leben steckt voller Risiken«, sagte er, und: »Niemand verbietet deshalb das Leben, weil es das Risiko birgt, gelegentlich vorzeitig zu enden«. (2)

Ja, ja – das Leben spielt nun einmal so. Es läßt Flugzeuge spielerisch im Zentimeterabstand aneinander vorbeirasen – zur Steigerung der Lebensfreude von Hunderttausenden. Das Todesrisiko war dabei, nachträglich betrachtet, nicht hoch. Hundert von etwa dreihunderttausend Zuschauern – das bedeutete für den einzelnen eine Wahrscheinlichkeit von etwa 3 x 10 hoch -4, also wenig mehr als doppelt so viel wie das Risiko eines »durchschnittlichen deutschen Einwohners«, innerhalb eines Jahres durch einen Verkehrsunfall zu sterben: 10000 geteilt durch 80 Millionen sind 1,25 x 10 hoch -4. Anders herum ausgedrückt: Man müßte 8000 Jahre leben, um eine vernünftige Chance zu haben, so den Tod zu finden. Man lebt aber nur etwa ein Hundertstel dieser Zeit, und deshalb ist das Verkehrsrisiko selbstverständlich akzeptabel. Jeder, der sich das Augenmaß bewahrt hat, wird einsehen, daß ein Tempolimit oder eine Senkung der Trunkenheitsgrenze unter 0,8 Promille nicht nur deutlich schwerer wiegende volkswirtschaftliche Schäden verursachen würde als ein paar tausend Tote pro Jahr, sondern daß vor allem auch der Verlust an Lebensfreude, der ja Milliarden von Lebensjahren der Bevölkerungsmehrheit beträfe, durch den Gewinn von hunderttausend Lebensjahren einer Minderheit nicht wettzumachen wäre.

Ein anderes typisches Risiko für den durchschnittlichen Deutschen, nämlich im zwanzigsten Jahrhundert durch Kriegseinwirkung ums Leben zu kommen, war aufs Jahr gerechnet ebenfalls nicht viel höher als das im Straßenverkehr (falls nicht noch in den nächsten vier Jahren ganz Unerwartetes geschieht). Schätzen wir ganz grob 10 Millionen Kriegsopfer unter den etwa 200 Millionen Deutschen in diesen hundert Jahren, so kommen wir auf ein Risiko von etwa 5 x 10 hoch -4 pro Person und Jahr. Auch das schien der überwältigenden Mehrheit offenbar noch akzeptabel.

Doch selbst das heute so penetrant verteufelte Risiko starker Raucher, an Lungenkrebs zu sterben, ist kaum zehnmal höher. Man muß den Jahreswert schon mit 40 Jahren Raucherleben multiplizieren, um auf etwa 20 Prozent zu kommen. Erst damit liegt man in der Nähe des Risikos, daß ein durchschnittlicher Nichtraucher durch Krebs beliebiger Art stirbt. Dank medizinischem Fortschritt werden eben viele von uns alt, und so ist Krebs selbst für gesund Lebende eine der normalsten Todesursachen geworden. Obendrein tritt ja auch der Raucherkrebs häufig erst in höherem Alter auf. Zählt man also nicht einfach die Todesfälle, sondern – viel sinnvoller – die verlorenen Lebensjahre, so schneidet das Rauchen wohl kaum noch schlechter ab als der Krieg...

Für den einzelnen Raucher freilich mag die eigene Widerstandskraft sogar ein wichtigerer Faktor sein als sein Laster – und sie hängt wohl als Ursache wie als Wirkung auch mit der Lebensfreude zusammen. Sie rauchen gern? Wer weiß, ob Sie dadurch nicht sogar Ihr Leben verlängern! Kennen Sie nicht einen lebensfrohen Neunzigjährigen, der sich regelmäßig nach dem Essen sein Pfeifchen stopft? Warum sollten nicht auch Sie zu den Ausgezeichneten gehören? Den hoffnungsvollen Glauben an die eigene Bevorzugung nennen Risikoforscher sarkastisch das »Nicht-Ich-Syndrom«. Aber ist er nicht ein Zeichen seelischer Gesundheit? Neurotisch ist es doch eher, hinter jedem innovativen Molekül ein Gift und hinter jedem der unvermeidlichen kleinen Zwischenfälle im Zivilisationsprozeß den Weltuntergang zu wittern! Müssen wir uns wirklich immer wieder über den jeweiligen »Schadstoff der Woche« ängstigen, den uns der Sensationsjournalismus auftischt? Wie recht doch Herr Culmann hatte! Es gibt eigentlich kaum größere Risiken als das normale Leben, das ja stets mit dem Tode endet (– mindestens bis die Wissenschaft auch dieses Problem endlich gelöst hat)! Warum nur haben viele Leute trotzdem dauernd so viel Angst vor relativ harmlosen Neuerungen? Sind die Menschen so unvernünftig? Oder sind sie von Panikmachern aufgehetzt, die irrationale Ängste anfachen, um darauf ihr politisches Süppchen zu kochen?

Schon immer tauchten bei der Verbreitung von Neuerungen Bedenken auf. Doch mußten sich die Meinungsführer und Machthaber früher nicht so sehr damit plagen wie heute. Diese waren ja, mindestens seit das Zeitalter des Rationalismus anbrach, oft eng verschwistert mit den »Verkäufern« des Fortschritts, der sich sonst gar nicht hätte verbreiten können. Erst die Demokratie schuf durch zunehmenden politischen Einfluß irrationaler Massen die Gefahr, daß risikofreudige Innovationen gehemmt werden. Kaum auszudenken, wie der Fortschritt sich hätte verzögern können, wenn man schon vor Erfindung der Eisenbahn die Demokratie, gar samt Frauenstimmrecht und Volksentscheid, eingeführt hätte! Heute zeichnet sich ja ab, daß wegen unbestimmter Ängste ganze wissenschaftlich-technische, ja auch militärische und sogar wirtschaftliche Entwicklungen abgebrochen und womöglich demnächst ganz zurückgenommen werden müssen.

Allerdings dreht sich die Diskussion dabei kaum je um Zahlen wie die eben vorgestellten. Der wachsende innere Widerstand gegen den Fortschritt scheint vielmehr ähnlich verschwommen motiviert wie das traditionelle Vertrauen in ihn, das ja auch nie ganz verschwunden ist. Quantitative Risikobetrachtungen stammen durchweg nicht von den Ängstlichen, sondern von Leuten, die rechnen können und etwas verkaufen wollen. Die Verwissenschaftlichung soll dazu verhelfen, die »Emotionen« in den Griff der Experten zu bringen. Warum gelingt das so schlecht?

Eine von der EG-Kommission beauftragte Wissenschaftlergruppe, (3) die sich mit der Akzeptanz von Atomkraftwerken beschäftigte, zeigte sich besonders beeindruckt von einer amerikanischen Studie. Deren Ergebnisse, so meinen sie, »zeigen, daß die Kernenergie bezüglich der Risikoakzeptanz eine einzigartige Stellung einnimmt. Die Gründe für die Antipathie gegen dieses Risiko müssen psychometrischer Natur sein. Die tief verwurzelte Ablehnung mag mit dem gewaltsamen Beginn der Kernspaltung im Zweiten Weltkrieg zu tun haben oder mit Angst oder mit einer Reihe anderer unerkannter Faktoren. Wir konnten keinerlei spezifische Faktoren identifizieren, die das Phänomen erklären würden. Weitere Studien werden nötig sein, um es zu verstehen.«

Drängt sich da nicht der Wunsch nach ganz anderen »psychometrischen« Studien auf? Sollte man nicht lieber an solchen Wissenschaftlern nach den mentalen Vorgängen fahnden, die es ihnen unmöglich machen, Gründe des Widerstandes gegen die großtechnische Nutzung der Kernenergie und andere Abenteuer wahrzunehmen? Wären nicht diese von der Industrie und ihren politischen Freunden mit der Risikoanalyse beauftragten Forscher selbst ein faszinierender Forschungsgegenstand für Psychologen und Soziologen? Sie scheinen wirklich nicht zu verstehen, warum die Leute ein Risiko nicht endlich zufrieden akzeptieren, wenn man es nach hinlänglicher Mittelung als kleine Zahl präsentiert. »Woran sollte man denn noch glauben, wenn nicht an Zahlen?« fragen sie – aber das zeigt auch, warum es sich kaum lohnt, sich ernsthaft mit seelischen Regungen solcher Leute zu beschäftigen, also etwa nach entwicklungspsychologischen, charakterlichen oder moralischen Wurzeln ihrer Gewissenlosigkeit zu suchen, die doch nur auf einem Mangel an glaubhaften Zahlen beruht. Werfen wir lieber einen Blick auf die Methoden, mit denen sie versuchen, sich und uns endlich ein zuverlässigeres, computergestütztes Künstliches Gewissen zu schaffen, das jener Künstlichen Intelligenz angemessen wäre, die ohnehin bald die Herrschaft wird übernehmen müssen. (Hier kann ich mir nicht verkneifen, wieder daran zu erinnern, daß die übliche englische Abkürzung AI – für artificial intelligence – sich auch als artificial imbecility – Künstlicher Schwachsinn – deuten läßt...)

Auf dem Verordnungsweg zum Stand der Wissenschaft

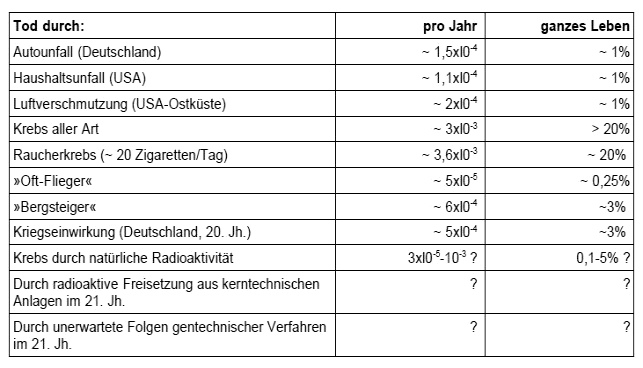

Fassen wir für Leser, die es nicht gewohnt sind, in Zahlen zu denken, noch einmal zusammen: Wenn wegen zu hoher Komplexität eines Systems die Ursachen und Wirkungen nicht in allen Details analysierbar sind, so versucht man, die erwartete Häufigkeit eines Schadens als Wahrscheinlichkeit zu definieren – eben als sogenanntes Risiko. Die Wahrscheinlichkeit, daß bei einem bestimmten Tun oder Lassen gewisse unerwünschte Folgen (Tod, Krankheit, Vermögensschäden etc.) auftreten, kann etwa pro Einzelereignis, pro Jahr oder pro mittlerer Lebensdauer angegeben werden. Ein Risiko von einem Tausendstel oder l0 hoch -3 pro Jahr bedeutet beispielsweise, daß von tausend Teilnehmern einer gewissen Aktivität jährlich durchschnittlich einer betroffen ist, daß also der einzelne im Durchschnitt wahrscheinlich etwa tausend Jahre warten muß, bis er dran ist – oder daß von 365000 Menschen durchschnittlich jeden Tag einer dran ist. Die Tabelle zeigt nochmals einige Beispiele für die Größenordnung des Todesrisikos durch verschiedene Einwirkungen, teils im Mittel über alle Einwohner, teils im Mittel über eine gewisse Gruppe.

Erinnert sich noch jemand an die Katastrophe beim Flugtag 1988 in Ramstein, als zwei Jagdflugzeuge sich berührten und in die Zuschauermassen stürzten? An die hundert Menschen starben sofort oder nach wochenlangem Todeskampf, und wohl noch mehr wurden für den Rest ihres Lebens entstellt. Viele meinten damals, solche Veranstaltungen dürften nicht mehr zugelassen werden. Der damalige Präsident des Deutschen Aero-Clubs und frühere Chef der Lufthansa, Herbert Culmann, aber begriff sofort, wie kleinmütig ein solches Verbot gewesen wäre. »Das Leben steckt voller Risiken«, sagte er, und: »Niemand verbietet deshalb das Leben, weil es das Risiko birgt, gelegentlich vorzeitig zu enden«. (2)

Ja, ja – das Leben spielt nun einmal so. Es läßt Flugzeuge spielerisch im Zentimeterabstand aneinander vorbeirasen – zur Steigerung der Lebensfreude von Hunderttausenden. Das Todesrisiko war dabei, nachträglich betrachtet, nicht hoch. Hundert von etwa dreihunderttausend Zuschauern – das bedeutete für den einzelnen eine Wahrscheinlichkeit von etwa 3 x 10 hoch -4, also wenig mehr als doppelt so viel wie das Risiko eines »durchschnittlichen deutschen Einwohners«, innerhalb eines Jahres durch einen Verkehrsunfall zu sterben: 10000 geteilt durch 80 Millionen sind 1,25 x 10 hoch -4. Anders herum ausgedrückt: Man müßte 8000 Jahre leben, um eine vernünftige Chance zu haben, so den Tod zu finden. Man lebt aber nur etwa ein Hundertstel dieser Zeit, und deshalb ist das Verkehrsrisiko selbstverständlich akzeptabel. Jeder, der sich das Augenmaß bewahrt hat, wird einsehen, daß ein Tempolimit oder eine Senkung der Trunkenheitsgrenze unter 0,8 Promille nicht nur deutlich schwerer wiegende volkswirtschaftliche Schäden verursachen würde als ein paar tausend Tote pro Jahr, sondern daß vor allem auch der Verlust an Lebensfreude, der ja Milliarden von Lebensjahren der Bevölkerungsmehrheit beträfe, durch den Gewinn von hunderttausend Lebensjahren einer Minderheit nicht wettzumachen wäre.

Ein anderes typisches Risiko für den durchschnittlichen Deutschen, nämlich im zwanzigsten Jahrhundert durch Kriegseinwirkung ums Leben zu kommen, war aufs Jahr gerechnet ebenfalls nicht viel höher als das im Straßenverkehr (falls nicht noch in den nächsten vier Jahren ganz Unerwartetes geschieht). Schätzen wir ganz grob 10 Millionen Kriegsopfer unter den etwa 200 Millionen Deutschen in diesen hundert Jahren, so kommen wir auf ein Risiko von etwa 5 x 10 hoch -4 pro Person und Jahr. Auch das schien der überwältigenden Mehrheit offenbar noch akzeptabel.

Doch selbst das heute so penetrant verteufelte Risiko starker Raucher, an Lungenkrebs zu sterben, ist kaum zehnmal höher. Man muß den Jahreswert schon mit 40 Jahren Raucherleben multiplizieren, um auf etwa 20 Prozent zu kommen. Erst damit liegt man in der Nähe des Risikos, daß ein durchschnittlicher Nichtraucher durch Krebs beliebiger Art stirbt. Dank medizinischem Fortschritt werden eben viele von uns alt, und so ist Krebs selbst für gesund Lebende eine der normalsten Todesursachen geworden. Obendrein tritt ja auch der Raucherkrebs häufig erst in höherem Alter auf. Zählt man also nicht einfach die Todesfälle, sondern – viel sinnvoller – die verlorenen Lebensjahre, so schneidet das Rauchen wohl kaum noch schlechter ab als der Krieg...

Für den einzelnen Raucher freilich mag die eigene Widerstandskraft sogar ein wichtigerer Faktor sein als sein Laster – und sie hängt wohl als Ursache wie als Wirkung auch mit der Lebensfreude zusammen. Sie rauchen gern? Wer weiß, ob Sie dadurch nicht sogar Ihr Leben verlängern! Kennen Sie nicht einen lebensfrohen Neunzigjährigen, der sich regelmäßig nach dem Essen sein Pfeifchen stopft? Warum sollten nicht auch Sie zu den Ausgezeichneten gehören? Den hoffnungsvollen Glauben an die eigene Bevorzugung nennen Risikoforscher sarkastisch das »Nicht-Ich-Syndrom«. Aber ist er nicht ein Zeichen seelischer Gesundheit? Neurotisch ist es doch eher, hinter jedem innovativen Molekül ein Gift und hinter jedem der unvermeidlichen kleinen Zwischenfälle im Zivilisationsprozeß den Weltuntergang zu wittern! Müssen wir uns wirklich immer wieder über den jeweiligen »Schadstoff der Woche« ängstigen, den uns der Sensationsjournalismus auftischt? Wie recht doch Herr Culmann hatte! Es gibt eigentlich kaum größere Risiken als das normale Leben, das ja stets mit dem Tode endet (– mindestens bis die Wissenschaft auch dieses Problem endlich gelöst hat)! Warum nur haben viele Leute trotzdem dauernd so viel Angst vor relativ harmlosen Neuerungen? Sind die Menschen so unvernünftig? Oder sind sie von Panikmachern aufgehetzt, die irrationale Ängste anfachen, um darauf ihr politisches Süppchen zu kochen?

Schon immer tauchten bei der Verbreitung von Neuerungen Bedenken auf. Doch mußten sich die Meinungsführer und Machthaber früher nicht so sehr damit plagen wie heute. Diese waren ja, mindestens seit das Zeitalter des Rationalismus anbrach, oft eng verschwistert mit den »Verkäufern« des Fortschritts, der sich sonst gar nicht hätte verbreiten können. Erst die Demokratie schuf durch zunehmenden politischen Einfluß irrationaler Massen die Gefahr, daß risikofreudige Innovationen gehemmt werden. Kaum auszudenken, wie der Fortschritt sich hätte verzögern können, wenn man schon vor Erfindung der Eisenbahn die Demokratie, gar samt Frauenstimmrecht und Volksentscheid, eingeführt hätte! Heute zeichnet sich ja ab, daß wegen unbestimmter Ängste ganze wissenschaftlich-technische, ja auch militärische und sogar wirtschaftliche Entwicklungen abgebrochen und womöglich demnächst ganz zurückgenommen werden müssen.

Allerdings dreht sich die Diskussion dabei kaum je um Zahlen wie die eben vorgestellten. Der wachsende innere Widerstand gegen den Fortschritt scheint vielmehr ähnlich verschwommen motiviert wie das traditionelle Vertrauen in ihn, das ja auch nie ganz verschwunden ist. Quantitative Risikobetrachtungen stammen durchweg nicht von den Ängstlichen, sondern von Leuten, die rechnen können und etwas verkaufen wollen. Die Verwissenschaftlichung soll dazu verhelfen, die »Emotionen« in den Griff der Experten zu bringen. Warum gelingt das so schlecht?

Eine von der EG-Kommission beauftragte Wissenschaftlergruppe, (3) die sich mit der Akzeptanz von Atomkraftwerken beschäftigte, zeigte sich besonders beeindruckt von einer amerikanischen Studie. Deren Ergebnisse, so meinen sie, »zeigen, daß die Kernenergie bezüglich der Risikoakzeptanz eine einzigartige Stellung einnimmt. Die Gründe für die Antipathie gegen dieses Risiko müssen psychometrischer Natur sein. Die tief verwurzelte Ablehnung mag mit dem gewaltsamen Beginn der Kernspaltung im Zweiten Weltkrieg zu tun haben oder mit Angst oder mit einer Reihe anderer unerkannter Faktoren. Wir konnten keinerlei spezifische Faktoren identifizieren, die das Phänomen erklären würden. Weitere Studien werden nötig sein, um es zu verstehen.«

Drängt sich da nicht der Wunsch nach ganz anderen »psychometrischen« Studien auf? Sollte man nicht lieber an solchen Wissenschaftlern nach den mentalen Vorgängen fahnden, die es ihnen unmöglich machen, Gründe des Widerstandes gegen die großtechnische Nutzung der Kernenergie und andere Abenteuer wahrzunehmen? Wären nicht diese von der Industrie und ihren politischen Freunden mit der Risikoanalyse beauftragten Forscher selbst ein faszinierender Forschungsgegenstand für Psychologen und Soziologen? Sie scheinen wirklich nicht zu verstehen, warum die Leute ein Risiko nicht endlich zufrieden akzeptieren, wenn man es nach hinlänglicher Mittelung als kleine Zahl präsentiert. »Woran sollte man denn noch glauben, wenn nicht an Zahlen?« fragen sie – aber das zeigt auch, warum es sich kaum lohnt, sich ernsthaft mit seelischen Regungen solcher Leute zu beschäftigen, also etwa nach entwicklungspsychologischen, charakterlichen oder moralischen Wurzeln ihrer Gewissenlosigkeit zu suchen, die doch nur auf einem Mangel an glaubhaften Zahlen beruht. Werfen wir lieber einen Blick auf die Methoden, mit denen sie versuchen, sich und uns endlich ein zuverlässigeres, computergestütztes Künstliches Gewissen zu schaffen, das jener Künstlichen Intelligenz angemessen wäre, die ohnehin bald die Herrschaft wird übernehmen müssen. (Hier kann ich mir nicht verkneifen, wieder daran zu erinnern, daß die übliche englische Abkürzung AI – für artificial intelligence – sich auch als artificial imbecility – Künstlicher Schwachsinn – deuten läßt...)

Auf dem Verordnungsweg zum Stand der Wissenschaft

Fassen wir für Leser, die es nicht gewohnt sind, in Zahlen zu denken, noch einmal zusammen: Wenn wegen zu hoher Komplexität eines Systems die Ursachen und Wirkungen nicht in allen Details analysierbar sind, so versucht man, die erwartete Häufigkeit eines Schadens als Wahrscheinlichkeit zu definieren – eben als sogenanntes Risiko. Die Wahrscheinlichkeit, daß bei einem bestimmten Tun oder Lassen gewisse unerwünschte Folgen (Tod, Krankheit, Vermögensschäden etc.) auftreten, kann etwa pro Einzelereignis, pro Jahr oder pro mittlerer Lebensdauer angegeben werden. Ein Risiko von einem Tausendstel oder l0 hoch -3 pro Jahr bedeutet beispielsweise, daß von tausend Teilnehmern einer gewissen Aktivität jährlich durchschnittlich einer betroffen ist, daß also der einzelne im Durchschnitt wahrscheinlich etwa tausend Jahre warten muß, bis er dran ist – oder daß von 365000 Menschen durchschnittlich jeden Tag einer dran ist. Die Tabelle zeigt nochmals einige Beispiele für die Größenordnung des Todesrisikos durch verschiedene Einwirkungen, teils im Mittel über alle Einwohner, teils im Mittel über eine gewisse Gruppe.

Abgesehen von den letzten drei Zeilen sind die Zahlen letztlich durch Abzählen wirklicher Ereignisse gewonnen. Beispiel: Wie viele Leute gingen pro Jahr klettern, und wie viele verunglückten dabei tödlich? Das macht sofort klar, daß das mittlere Risiko für den einzelnen nicht maßgeblich sein muß. Er kann sich auch bei manchen risikoreichen Aktivitäten noch immer so verhalten, daß sein persönliches Risiko weit unter dem mittleren bleibt – beispielsweise durch größere Vorsicht als Fußgänger oder Autofahrer, als Kletterer am Berg oder als Benutzer einer Leiter beim Fensterputzen und Reinigen der Dachrinne. Auch bei Krebs bestehen große individuelle Unterschiede in Empfindlichkeit und Abwehrstärke und natürlich vor allem in der Häufigkeit und Intensität des Kontakts mit Karzinogenen, so daß der einzelne sein Risiko durch die Lebensweise beeinflussen kann. Nur sind mögliche Vorsichtsmaßnahmen hier nicht immer so einleuchtend und allgemein anerkannt wie etwa beim Rauchen oder Klettern – nämlich: »Bleiben lassen!« Beim Kriegführen, beim Betrieb von Atomreaktoren, bei Nutzung chemischer und genetischer Techniken, ja bei fast allen gesellschaftlichen Unternehmungen ist das schwieriger. Hier steht die Aussicht auf Beute oder auf anderen gewaltigen gesellschaftlichen Nutzen einer so einfachen Empfehlung entgegen.

Die Tabelle erinnert uns aber auch an einen anderen wichtigen Unterschied: Die in den letzten drei Zeilen angeführten Risiken (wie auch die Risiken vieler anderer neuer Techniken) sind von anderer Art als die weiter oben genannten. Sie lassen sich nicht durch Abzählen wirklicher Ereignisse bestimmen. Entweder weil viele verschiedene Ursachen ähnliche Phänomene hervorbringen (wie beim Krebs, wo eine Zuordnung immerhin ansatzweise durch umfangreiche epidemiologische Untersuchungen möglich wäre), oder weil die Ereignisse zwar folgenreich, aber doch sehr selten sind (wie Reaktorkatastrophen), oder weil viele unabsehbare Folgen erst nach Jahrzehnten sichtbar werden (wie bei der Anreicherung von Spurengasen in der Atmosphäre und von Giften in Böden und Gewässern), oder weil die Anwendung der entsprechenden Technik gerade erst begonnen hat (wie bei der Gentechnik). Die Wahrscheinlichkeit von Schäden ist dann zunächst völlig unbekannt.

Das ist in einem Rechtsstaat untragbar. Hier muß jedes Handeln justitiabel sein! Wie sollen denn die Behörden Anlagen und Verfahren genehmigen, und wie sollen Richter diese Genehmigungen beim Widerspruch einzelner Betroffener oder Fortschrittsfeinde beurteilen können, wenn die möglichen Folgen völlig unbekannt sind? Genehmigen will und muß man doch schließlich – sonst würde sich das Kapital einfach einen anderen Standort für jene Aktivitäten suchen – und dann wohl bald auch für alle anderen! Damit aber wären nicht nur Leben oder Gesundheit einer Minderheit bedroht, sondern es wäre bekanntlich uns allen jede Lebensgrundlage entzogen! Der Staat muß also die Wissenschaft dazu bringen, Fragezeichen durch Zahlen zu ersetzen, die in Gesetze, Verordnungen und richterliche Urteile eingehen können.

Im wesentlichen gilt noch immer der Grundsatz: Man darf alles tun, solange konkrete schädliche Folgen nicht wissenschaftlich nachgewiesen oder wenigstens aufgrund wissenschaftlicher Argumente höchst wahrscheinlich zu erwarten sind. Nun sind aber durch den wissenschaftlichen Fortschritt die Meßmethoden für Schadstoffe wie für Schäden immer empfindlicher geworden, und obendrein sind natürlich durch den Fortschritt der Zeit selbst immer mehr Risiken, die einem pro Jahr vernachlässigbar erscheinen mochten, manifest geworden. Wer stündlich eine neue chemische Verbindung herstellt, die es vorher auf der Erde oder gar im Universum nicht gab, der ist zunächst stolz auf seine Schöpferkraft. Hat man das freilich hundert Jahre lang getan und immer mehr von diesen Innovationen in wachsenden Mengen freigesetzt, dann zeigen sich allmählich Probleme – zum Beispiel, daß etwa stündlich eine lebendige Art ausstirbt, die zu ihrer Entstehung Jahrmillionen brauchte. (Inzwischen mögen es nach Aussage führender konservativer Biologen sogar schon eher zehn Arten pro Stunde sein...)

Nun geht es also offensichtlich darum, daß die Wissenschaft mögliche Schäden einer technischen Innovation rechtzeitig abschätzt. Auf dieser Basis sollen dann die Genehmigungsbehörden über neue Projekte entscheiden. Leider liegt es aber im Wesen komplexer Fragen, daß sich in ihnen auch Wissenschaftler nicht leicht einigen – und schon gar nicht in Eile. Wenn sie nicht so eng zusammenarbeiten, daß ihre Vorurteile und Fehler identisch werden, werden sie bei der Abschätzung eines Risikos im allgemeinen lauter verschiedene Zahlen finden. Das hat freilich auch seinen Vorteil: Nun weiß man, wer die kleineren Zahlen findet! Und damit liegt nahe, was zu tun ist, um ein Projekt genehmigungsfähig zu machen: Man muß Kommissionen aus jenen Wissenschaftlern berufen, bei denen die Zahlen klein genug herauskamen!

Da die anderen Wissenschaftler, jene mit den zu großen Zahlen, nicht in der Kommission sind, also auch weniger Geld verdienen, gelten sie fortan in der Öffentlichkeit und schließlich sogar unter Kollegen als die schlechteren Wissenschaftler und als weniger glaubwürdig. Obendrein kann das viele Geld, das hinter den Projekten steckt, auch durch Förderung von »Öffentlichkeitsarbeit« ein wenig nachhelfen, daß sie als defätistische Fortschrittsfeinde oder senile Pessimisten erkennbar werden. Daß sie nichts wissenschaftlich Haltbares zu sagen haben, wird endgültig klar, wenn die nationalen Kommissionen aus den Leuten, die kleinere Zahlen produzieren, sich in einer noch höher bezahlten internationalen Kommission vereinigt haben, die nun mit dem definitionsgemäß höchsten Sachverstand die Risiken quantifiziert und entsprechende Grenzwertempfehlungen gibt. Spätestens dann ist der auf dem Verordnungsweg gewonnene »Stand der Wissenschaft« gesichert...

Damit kein Mißverständnis aufkommt: In diesem Verfahren kann alles mit bestem Willen geschehen. Korruption mag zwar oft naheliegen, ist aber fürs Funktionieren keineswegs notwendig. Es genügt der gesellschaftlich organisierte Wille zu schnellerer Innovation und mehr globaler Vereinheitlichung. Diese Ideologie ist es, die die projektfördernde theoretische Vereinfachung komplexer Sachverhalte erzwingt. Hat sich erst einmal eine Gruppe normalbegabter Wissenschaftler zu diesem Zweck zusammengefunden und wird dafür zusätzlich gefördert, dann kommt es auch ohne jede Beteiligung von »Bosheit« leicht zum absurdesten, geradezu »kriminell« wirkenden Verhalten. Die Geschichte ist voll von Beispielen. Auf einige werden wir zurückkommen, doch wollen wir zuvor einigen Fragen, die immer wieder auftauchen müssen, etwas grundsätzlicher nachgehen.

Probabilistische Risikoanalyse – Beispiel Kernenergie

Bei genauerer Betrachtung wäre der Risikobegriff so komplex wie das Leben. Nehmen wir das Beispiel »Risiken der Kernenergienutzung«. Welche vorstellbaren Schäden soll man überhaupt zu bewerten versuchen? Was soll man zählen? Die unmittelbaren menschlichen Todesfälle? (»Beim Unfall in Tschernobyl gab es 31 Tote.«) Oder die verlorenen Lebensjahre, wenn der Tod nicht sofort, sondern erst später eintritt? (Dann sind es durch Tschernobyl vermutlich Millionen von Lebens-Jahren.) Oder die durch Gesundheitsschäden an »Lebensqualität« ärmer gewordenen Lebensjahre? Dann genügte ja das Zählen nicht, und man müßte auch noch gewichten! Und was ist mit den Erbschäden bei den Nachkommen? Mit den Schäden an der Pflanzen- und Tierwelt? Mit etwaigen Einflüssen aufs Klima? Was soll man da zählen oder wiegen? Und wie sollte man es zum Beispiel werten, wenn beim weiteren Übergang zur Atomenergienutzung zum Zwecke der Risikoverminderung die Macht von Verwaltung und Polizei wachsen müßte, wenn etwa aus Sicherheitsgründen, oder wegen der Proliferationsgefahr, eine Art dauernden Ausnahmezustands entstünde? Wäre das nicht vielleicht sogar positiv zu bewerten, gehörte also eigentlich auf die Waagschale der Chancen, weil es Arbeitsplätze im gehobenen Dienstleistungssektor schüfe, während ja solare Energietechniken nur Arbeit in simpler Produktion und Wartung und im Reparaturgewerbe brächten? Und schließlich die scheinbar noch schwierigere Frage: Wie soll man denn gesellschaftliche und biosphärische Folgen bewerten, wenn sie erst in fernerer Zukunft zu erwarten sind?

Für eine wissenschaftliche Risikodefinition sind solche Gesichtspunkte natürlich ungeeignet. Hohe Komplexität eines Systems bedeutet geradezu definitionsgemäß, daß das Wesentliche nicht wissenschaftlicher Analyse zugänglich ist. Wissenschaft beginnt zwangsläufig mit der Reduktion auf hinreichend Simples. Meist reduziert sie das vielfältige Risiko für Natur und Gesellschaft auf die Frage in der obigen Tabelle: Wie wahrscheinlich ist es, daß Menschen durch Freisetzung von Radioaktivität aus einer bestimmten kerntechnischen Anlage getötet werden? Schon die Frage nach Krankheiten, die nicht zum Tode führen, würde ein so weites Feld eröffnen, daß man sie meist gar nicht erst stellen mag.

Um wenigstens auf die einfachste Frage eine Antwort zu finden, muß man abschätzen, wieviel Aktivität freigesetzt werden wird – im angestrebten »Normalbetrieb«, wie auch bei allen zu erwartenden Zwischenfällen. Um den letzteren überhaupt Zahlen zuordnen zu können, hat man die sogenannte »probabilistische Risikoanalyse« entwickelt: Da die Ereignisse, die man zählen müßte, in der bisherigen Praxis nur selten oder noch gar nicht stattgefunden haben, versucht man auf dem Papier alle möglichen Ereignisketten zu konstruieren, die zu ihnen führen könnten. Dann versucht man, jedem Glied jeder solchen Kette eine Wahrscheinlichkeit zuzuordnen – entweder aufgrund von Erfahrungen mit verwandten Bauteilen und Abläufen in anderen Anlagen oder notfalls durch Spekulation. (Beispiele: Platzen eines Kessels? Versagen einer Dichtung oder eines Ventils? Ausfall eines Meßinstruments? Fehlerhafte Bedienung eines Schalters?) Nun muß man untersuchen, wie weit die betrachteten Glied-Ereignisse voneinander unabhängig sind – dann kann man die Gesamtwahrscheinlichkeit jeder Kette ausrechnen und schließlich die Wahrscheinlichkeiten aller Ketten addieren. Mit diesem Verfahren kam man zum Beispiel zu der Aussage, ein Kernschmelzen in einem deutschen Reaktorkern sei höchstens einmal in zehntausend Betriebsjahren zu erwarten. (4)

Weiter geht‘s dann mit Betrachtungen zum optimalen »Unfallmanagement«: Wie kann durch Konstruktionsmerkmale (etwa die »Wallmann-Ventile« zur gezielten »Druckentlastung« im Falle drohender Explosion) und durch Verhaltensregeln fürs Personal dafür gesorgt werden, daß mittels kontrollierter Freisetzung von Radioaktivität eine eventuell noch katastrophalere Freisetzung unwahrscheinlicher gemacht wird? Über solche Verfahren einer neuen »nuklearen Sicherheitskultur« wird öffentlich erst seit einer Konferenz (November 1988 in München) gesprochen, auf der die weltweite Nuclear Community gemeinsame Sicherheitsstandards zu formulieren versuchte. Ein Zitat von dort: »Dem Streben nach Akzeptanz für die Kernenergie ist es abträglich, wenn Unterschiede zwischen den Sicherheitsniveaus verschiedener Staaten existieren oder diskutiert werden.« (5) Bemerkenswert ist auch die seither herrschende Sprachregelung: Was ich hier noch »probabilistische Risikoanalyse« nenne, heißt in der nuklearen Gemeinschaft nun »probabilistische Sicherheitsanalyse« – abgekürzt nicht mehr PRA, sondern PSA. So leicht läßt sich »risk« durch »safety« ersetzen.

Die mit viel gutem Willen ermittelten Wahrscheinlichkeiten für bestimmte Typen von Unfallereignissen muß man nun als Ausgangspunkt für weitere hypothetische Ereignisketten nehmen: Welche Bruchteile des Inventars an verschiedenen Nukliden werden in Luft, Wasser und Boden freigesetzt? Wie verbreiten sie sich weiter? Wie werden sie von Lebewesen aufgenommen? Was gelangt direkt oder über die Nahrungskette in den Menschen? In welchen Organen wird es wie lange gespeichert? Wie wirkt sich das schließlich auf die Gesundheit und die Erbanlagen der Bewohner in verschiedenen Abständen vom Unfallort aus, und wie viele Todesfälle, Krankheiten und Erbschäden werden dadurch in verschiedenen Zeiträumen verursacht? Wenn berufene Kommissionen diese Fragen beantwortet haben (von Fragen nach anderen biosphärischen Folgen ganz zu schweigen), haben wir endlich eine der Zahlen, die ein Fragezeichen in der Tabelle ersetzen sollen! Gibt es Gründe, sie zu glauben?

Restrisiko

Jeder gibt zu, daß den Forschern schon bei der Abschätzung der Unfallwahrscheinlichkeit wichtige Ereignisketten entgehen müssen. Man spricht zwar vernünftigerweise oft nicht mehr von Ereignisketten, sondern vom »Fehlerbaum«, aber dieses Bild steht auf dem Kopf. Die Zweige eines Baumes wachsen aus den Ästen, wie diese aus dem Stamm. Bei Reaktorkatastrophen aber ist es umgekehrt: Das dicke Ende kommt nach! Der Vorsitzende der deutschen Reaktorsicherheitskommission behauptete einst in öffentlichen Vorträgen, die vielen kleinen Verzweigungen möglicher Ursachenketten seien doch in einer »Einhüllenden« enthalten – ähnlich wie die Gesamtgestalt eines Baumes im wesentlichen schon durch die Gestalt der großen Äste bestimmt sei. Das verschwommene Bild sollte wohl der eigenen Beruhigung wie der des Publikums dienen. Es sollte die Hilflosigkeit gegenüber der Tatsache verschleiern, daß praktisch unendlich viele verschiedene Linien von der »fraktalen« Außengrenze des Baumes zum Stamm hin gezogen werden können. Die »Ursachen« einer Katastrophe verzweigen sich in der Vergangenheit in unermeßlich viele, aber oft nur scheinbar immer »unwichtigere« Ereignisse. Die Enden, das heißt die Anfänge dieser unendlich vielen Würzelchen, sind schließlich »wirkliche Zufälle« (– letztlich sogar die spontanen mikroskopischen Schwankungen, von denen die Physiker reden). Um etwa die Wahrscheinlichkeit eines großen Unfalls mit Freisetzungen aus dem radioaktiven Inventar abzuschätzen, müßte man alle verschiedenen möglichen Wurzelnetze eines solchen Ereignisses erfassen. Die Menge der verschiedenen möglichen Vereinigungen von Pfaden zur schließlichen Katastrophe ist aber so unermeßlich groß, daß man nie sagen darf, man habe den wesentlichen Teil davon mit einer »Einhüllenden« gedanklich erfaßt.

Das zeigt sich auch in der Praxis ganz deutlich: Der Weg zu vielen der bekannt gewordenen Störfälle folgte »unfallauslösenden Ereignisketten«, die zuvor in keiner Risikostudie aufgetaucht waren. Die entscheidenden Stellen, an denen meist durch raffinierte Wechselwirkungen zwischen Mensch und Technik etwas »schiefging«, waren niemandem eingefallen. Kein Wunder! Was einem vorher einfiel, hat man ja meist durch technische und organisatorische Maßnahmen bereits zu verhindern oder in den Folgen zu begrenzen versucht. In einer komplizierten technischen Anlage, bedient von Menschen, eingebettet in eine komplexe Gesellschaft und natürliche Umgebung, müssen immer wieder Abläufe vorkommen, die keinem Forscher vorher eingefallen sind. Darunter müssen auch solche sein, bei denen sich winzige Fehler an unscheinbaren Würzelchen zu unermeßlichen Folgen auswachsen. Die Menge völlig verschiedener Wege zur Katastrophe ist also unfaßbar groß. Wenn deshalb versucht wird, den »unberechenbaren« Menschen weitgehend auszuschalten, wird das aber im allgemeinen nicht besser. Ich muß nur wieder daran erinnern, wie viele verschiedene Möglichkeiten es gibt, ein paar Punkte durch gerade Striche miteinander zu verbinden: Schon bei 24 Punkten ist die Anzahl der verschiedenen möglichen Beziehungsmuster größer als die Zahl der Atome im Weltall...

In der Zusammenfassung der Tausende von Seiten umfassenden »Deutschen Risikostudie Kernenergie« war argumentiert worden, die unvermeidbare Unvollständigkeit bei der Erfassung der »auslösenden Ereignisse« sei dadurch berücksichtigt und ausgeglichen worden, daß man bei der Durchrechnung der erfaßten Möglichkeiten besonders vorsichtig, ja übermäßig »pessimistisch« vorgegangen sei. Das heißt: Unbekanntes glaubt man dadurch zu berücksichtigen, daß man das Bekannte besonders sorgfältig anschaut! – Wer mit dieser Art von Denken oder vielmehr Gedankenlosigkeit konfrontiert wird, beginnt sich zu fragen: Welchen Teil des gesamten Risikos mag man wohl überhaupt mit den üblichen Methoden der probabilistischen Analyse erfaßt haben? Sind es über 99 Prozent oder ist es weniger als ein Prozent? Und siehe da: Es gibt keine zuverlässige Antwort auf diese Frage! Das Restrisiko könnte größer sein als alle bisher theoretisch erfaßten Risiken zusammen – der »Super-GAU« wahrscheinlicher als der »GAU«!

Was antwortete der Forschungsminister auf solche Bedenken? Sie brächten keine neuen Erkenntnisse! Ich solle doch bitte etwaige Lücken der Studie »konkret und im einzelnen aufdecken«. Darüber hinaus sei »längerfristig durch den ständigen Vergleich der theoretischen Untersuchungen mit den praktischen Erfahrungen zu prüfen, ob sich neue Erkenntnisse ergeben können«. Mit anderen Worten: Der in den Nebel Rasende ist nicht durch vage Vermutungen zu stoppen, sondern nur durch Aufprall.

Wie sollen Genehmigungsbehörden und Justiz aber auch mit dieser Situation umgehen? Die »kleineren Zahlen« helfen doch nichts mehr, wenn man zugeben muß, daß sie nur einen unbekannten Bruchteil des gesamten Risikos betreffen. Die sogenannten Wahrscheinlichkeiten sind dann gar keine, denn sie sind nicht auf die Menge aller Möglichkeiten bezogen, das heißt »nicht auf Eins normiert«, wie Mathematiker sagen würden. Was tun mit dem nicht abschätzbaren Teil des Risikos, den man das Restrisiko genannt hat – in der Hoffnung, ein Rest sei ja schon definitionsgemäß etwas Kleines? Nun bleibt nichts als die Hoffnung auf Götter! Wie wird diese in einem Rechtsstaat institutionalisiert? Natürlich übers Verfassungsgericht! Dieses muß einfach bestätigen, daß »nach den Regeln der praktischen Vernunft« das Ungeahnte unberücksichtigt bleiben müsse und deshalb das Restrisiko unabhängig von seiner Größe »sozial akzeptabel« sei.

Damit wollte man vermutlich nicht für akzeptabel erklären, daß demnächst eine berühmte Stadt oder Landschaft unbewohnbar wird (was ja bedeutet hätte, daß man gerade den »Super-GAU«, der definitionsgemäß noch schlimmer wäre als der »größte anzunehmende Unfall«, für annehmbar erklärte – oh, diese schillernden Wörter!). Zwar weiß man, daß die Möglichkeit solcher Unfälle besteht und daß eine Wahrscheinlichkeit für ihr Eintreten nicht vernünftig abschätzbar ist – aber nach der »praktischen Vernunft« ist die Sache trotzdem klar: Es wird schon gutgehen! Sollten wir etwa doch Pech haben, dann sind wir jedenfalls nicht schuld. Dann war es »höhere Gewalt« – was auf englisch noch einleuchtender klingt: »An act of God«! Das heißt: Kernenergie ist verantwortbar. Auch im schlimmsten Fall wird man mit bestem Gewissen erklären, warum man die entsprechenden Anlagen trotz unvollständigen Wissens bauen durfte: »Nach dem damaligen Stand der Wissenschaft war mit diesem Ereignis nicht zu rechnen!« In der Tat: Mit etwas zu rechnen, wofür man gar keine Zahlen hat, wäre doch absolut irrational! Mit dem Restrisiko ist also nicht zu rechnen – und die Verfassungsrichter, die schließlich auch keine andere Vernunft als die praktische haben, müssen es für akzeptabel erklären. Sonst liefe ja gar nichts mehr in diesem Land!

Die tiefen Widersprüche in diesem für mich immer wieder verblüffenden Denkprozeß scheinen längst kaum noch jemandem den Schlaf zu rauben. Für die Öffentlichkeit deutlich wahrnehmbar und dokumentiert wurde er wohl erstmals im Zusammenhang mit der Frage der Reaktorsicherheit (im Wyhl-Urteil des Bundesverfassungsgerichts), aber das Prinzip dieses Verfahrens hat man mittlerweile auf praktisch alle Bereiche der »Folgenabschätzung« für technische und soziale Entwicklungen ausgedehnt. Wie sonst könnte man denn auch mit dem Problem des Restrisikos umgehen, nachdem sich herausgestellt hat, daß wir von lauter »hausgemachten« Untergangssymptomen bedrängt werden, die sich am Beginn der entsprechenden Hausmacherkünste einmal als vernachlässigbare Restrisiken darstellten? Ein bevorstehendes Umkippen des Erdklimas? Die Verdünnung der Ozonschicht und die entsprechende Bedrohung alles Lebendigen durch ultraviolette Strahlung? Der Abbau der Biosphäre durch immer rascheren Untergang von Arten? Bis zum »Weltuntergang«? – Lauter Restrisiken! Bleiben wir aber noch ein wenig beim relativ simplen Beispiel der Kernenergie, weil hier die Konsequenzen der sogenannten praktischen Vernunft leichter erkennbar sind. Hier fallen ja unter das Restrisiko auch mögliche Ereignisse, die gar nicht »ungeahnt« sind, die vielmehr fast jedem sofort einfallen, gegen die man aber praktisch ziemlich machtlos wäre – und mit denen man trotz fehlender Zahlen irgendwie glaubt rechnen zu müssen. Ein besonders eklatantes Beispiel ist die absichtliche Freisetzung großer Mengen von Radionukliden durch gezielten militärischen oder terroristischen Angriff. Wie wahrscheinlich ist es zum Beispiel, daß ein gut organisiertes Terrorkommando (vielleicht sogar entschlossen, sich selbst zu opfern, um schnurstracks in den Himmel zu kommen) mit Lastwagen in eine nukleare Anlage eindringt, mit Gas die Bedienungs- und Wachmannschaften ausschaltet, an ganz bestimmten Stellen eine von Kennern solcher Anlagen errechnete Menge von Sprengstoff anbringt, durch Explosion einen möglichst großen Teil des radioaktiven Inventars freisetzt, durch mitgebrachten Brennstoff ein Großfeuer entfacht – und so eine Stadt oder ein Land auf Generationen hinaus unbewohnbar macht? Hierfür eine Wahrscheinlichkeit abzuschätzen, hat noch nicht einmal ein Wissenschaftler gewagt.

Für die Benennung dieser Möglichkeit bin ich von Wissenschaftlern immer wieder kritisiert, ja beschimpft worden. (6) So etwas dürfe man nicht einmal denken! Warum nicht? Das ist in der Diskussion über die Kernenergie klar: Schon diese eine Möglichkeit reicht aus, um ohne jede quantitative Risikoabschätzung die sogenannte friedliche Nutzung der Kernenergie für tabu zu erklären! Allein wegen dieser Möglichkeit müßte jede Anhäufung größerer Mengen radioaktiver Nuklide an einem Ort grundsätzlich und für alle Zeiten geächtet werden – denn durch keinerlei technische oder organisatorische Mittel ließe sich ihre Freisetzung durch dumme Zufälle, Schlamperei oder Absicht zuverlässig ausschließen. Das macht die Kernenergienutzung zu einem der simpelsten Beispiele für den vernünftig gebotenen Umgang mit dem sogenannten Restrisiko: Dieses läßt sich hier einfach auf Null reduzieren! – Oder finden die praktische Vernunft und ihr Künstliches Gewissen etwa doch noch Auswege, um die bedingungslose Kapitulation zu vermeiden? Aber natürlich! Man muß die Sache nur von noch etwas höherer Warte aus betrachten.

Vogelperspektive

In den zehn Jahren seit dem Unglück von Tschernobyl starben auf der Erde rund eine Milliarde Menschen. Davon dreißig bei jenem bisher größten Atomunfall. Innerhalb des nächsten Vierteljahrhunderts werden an die zweieinhalb Milliarden Menschen sterben, das sind knapp halb so viele, wie es jetzt auf der Erde gibt. Bei fast einer halben Milliarde davon wird Krebs die Todesursache sein – doch höchstens etwa einer von tausend bis zehntausend dieser Krebsfälle wird wohl durch die aus der Ukraine stammende Radioaktivität verursacht sein. Wer da nach zehn Jahren noch immer von Tschernobyl redet, muß ein Panikmacher sein – oder ein von Panikmachern Irregeleiteter. Gemessen an so viel größeren, bedenkenlos akzeptierten Lebens- und Zivilisationsrisiken sind schließlich einige zigtausend oder sogar eine Million Opfer innerhalb einer Menschheitsgeneration vernachlässigbar.

Dabei ist das »Totezählen«, wie wir sahen, sogar noch ungerecht gegenüber den Freunden der Atomenergie und anderen Fortschrittswilligen. Auch der von Strahlung verursachte Krebs tritt überwiegend erst nach Jahrzehnten, also in höherem Alter auf. Es gehen also nicht ganze Leben verloren, sondern ein paar Lebensjahre. Statistiker werden vorrechnen können, daß auch die Zahl der durch Tschernobyl verlorenen Lebensjahre gegenüber der Zahl aller von Menschen gelebten Jahre klar vernachlässigbar sein wird. Schon das Wachstum der Weltbevölkerung macht sie wohl mehr als wett.

Solche Umlegung des Schadens auf die gesamte Menschheit muß ich nicht neu erfinden. Sie ist gang und gäbe bei politischen Anführern und ihren wissenschaftlichen Hand- und Kopflangern, die mit ihren Weltverbesserungsplänen aufs Ganze gehen. Diese Art der Betrachtung erzeugt eine ungeheure moralische Kraft. Die Einsicht, man habe durch eigene Aktivitäten zum Tod von Zehntausenden von Menschen beigetragen und noch weit mehr bis in ferne Generationen mit gesundheitlichen Schäden belastet – diese Einsicht löst dann keine unguten Gefühle oder gar schlechtes Gewissen aus. Im Gegenteil: Das Denken in großen Zusammenhängen ist erhebend! Man weiß doch, warum man das alles tun mußte! Darf man nicht letztlich sogar stolz sein? Hat man nicht Milliarden von Menschen mit Energie und vielem anderen versorgt? Ihnen also geradezu das Leben geschenkt? Hat nicht die ungeheure Mehrheit all jener, die man nicht umgebracht oder geschädigt hat, das Überleben eigentlich solchen Großtaten zu verdanken? Und wieviel mehr könnte man für sie tun! Würde nur endlich mehr Geld für Großforschung und Großtechnik bereitgestellt.

Es gibt noch eine andere Art von Menschheitswohltätern: Terroristen, die durch Attentate auf Repräsentanten einer ungerechten Gesellschaftsordnung endlich den Weg zum Wohl der Massen freibomben wollen. Merkwürdig ist, mit welchem Haß die beiden Arten von Wohltätern einander als Verbrecher ansehen. Kann einem nicht die ideologische Motivation von Terroristen als nahe verwandt mit jener der politischen, militärischen, wirtschaftlichen oder wissenschaftlich-technischen Macher erscheinen? Beide fühlen: »Wir wissen, wie die Welt besser wird! Aber ohne Opfer geht‘s nun mal nicht. Wo gehobelt wird, fallen Späne ...«

Seltsam: Ich mußte immer wieder darüber nachgrübeln, ob da nicht doch ein wesentlicher Unterschied besteht. Eine Erleuchtung kam mir nach den Ereignissen von Tschernobyl über einem Brief der Bonner Staatsanwaltschaft. Ich hatte gemeinsam mit einem Anwalt Strafanzeige wegen gemeinschaftlich versuchter schwerer Körperverletzung gegen die deutsche Strahlenschutzkommission gestellt, weil diese in ihren Begründungen für den Grenzwert des Jod-131 in Milch nur jene wissenschaftlichen Arbeiten zitiert hatte, die beruhigend wirkten. Bedenklichere wurden einfach unterschlagen. Die Staatsanwaltschaft konnte dies natürlich nicht leugnen, ließ mich jedoch wissen, sie sehe darin kein Anzeichen für bewußtes Fehlverhalten. Da wußte ich endlich wieder, was mir vor lauter abstrakten Erwägungen entfallen war: Es gibt Gut und Böse! Der Unterschied liegt im Bewußtsein der Täter!

Kein Staatsanwalt käme ja auf die Idee, nach einem Terrormord mitzuteilen, es bestehe kein Anlaß für straf-prozessuale Maßnahmen, weil bei einem einzigen Todesfall unter Millionen von Einwohnern die mittlere Belastung der Bevölkerung offensichtlich minimal gewesen sei. Es sind eben nicht tödliche Folgen einer Handlungsweise, die diese als Verbrechen definieren. Es ist der Wille! Terroristen wollen ja töten, die Anführer des technischen Fortschritts wollen dies normalerweise gewiß nicht. Nur selten kommt es vor, daß sich begeisterte Forscher an gesellschaftlich organisierte Verbrechen anhängen, um deren Opfer dankbar als wertvolle Gaben für die Wissenschaft auszuschlachten. So bereicherten etwa deutsche Hirnforscher die wissenschaftliche Erkenntnis durchs Präparieren von Gehirnen, die sie bei den Vollstreckern der »Euthanasie« oder der »Endlösung« bestellten (...wo sonst kam man an so viele interessante Gehirne...). Und die Forschung über Strahlenwirkungen profitierte davon, daß man »vergessen« hatte, beim Test der ersten amerikanischen Wasserstoffbombe (namens »Bravo«) am 1. März 1954 die Einwohner des dem Bikini-Atoll benachbarten Atolls Rongelap zu evakuieren, so daß man endlich über eine hervorragend geeignete Gruppe für Langzeituntersuchungen unter Bedingungen erheblicher radioaktiver Kontamination verfügte... Wie gesagt, so etwas kommt zwar vor, vielleicht sogar öfter, als wir gemeinhin glauben, aber das Normale ist es gewiß nicht. Nur Narren vermuteten sogar hinter dem Unglück von Tschernobyl böse Absichten.

Dagegen sind die Terroristen in der Tat direkt aufs Töten aus. An diesem ihrem Bewußtsein erkennen wir sie als Verbrecher – nicht etwa an der Menge der Opfer. (Ist diese besonders groß, ist das zuweilen sogar der späteren Verehrung der Täter in Nationalheiligtümern förderlich.) Eine Gemeinsamkeit liegt freilich darin, daß beide Sorten von Weltverbesserern fremdes Leben gegen Vorteile abwägen, die einer Gesellschaft oder der ganzen Welt zugute kommen sollen. (Eigener Vorteil spielt in der Motivation so edler Menschen natürlich keine Rolle.) Beginnt hier nicht der Unterschied schon wieder zu verschwimmen? Oder liegt er vielleicht darin, daß die Opfer der Mörder schon beim Planen der Tat einen Namen haben, die Opfer der Technokraten aber, wie die des Krieges, noch namenlos sind? Aber nein, auch das kann es nicht sein. Wüten nicht auch Terroristen immer öfter gegen namenlose Opfer? Als Unterschied bleibt wohl nur: Die einen glauben doch wenigstens in einer Ecke ihres Herzens an das Wunder, daß die Weltverbesserung ganz ohne Opfer abgehen könnte, nicht wahr? O weh! Auch das ist es nicht! Dann würden sie doch nicht ständig vom Abwägen reden. – Auch die Staatsanwaltschaft hat mir nicht geholfen. Ich bin wieder ganz durcheinander. Müssen wir die Moraltheologen fragen?

Nun gut – es gibt Förderer der Kernenergie, die wegen Tschernobyl ein schlechtes Gewissen haben. Sollten wir es damit nicht endlich genug sein lassen und nicht weiterhin so nachtragend sein? Jeder kann einmal Fehler machen. Das muß sogar sein. Ohne Fehler kann man nicht lernen. Zugegeben, das in Tschernobyl war ein bedauerliches Ereignis, aber nun wird‘s gewiß nicht wieder vorkommen. Es muß einmal Schluß sein mit dem Wühlen in der Vergangenheit! Wenden wir uns der Zukunft zu, die im eigenen Land liegt und in Europa. Was also ist mit den eigenen Reaktoren?

Wer die wissenschaftlich-technische Diskussion einigermaßen verfolgt, der weiß, daß auch bei ihnen Unfälle möglich sind, die ebensoviel oder gar mehr Radioaktivität freisetzen könnten als die Katastrophe in Tschernobyl. Selbst die schnelle Zerstörung des Sicherheitsbehälters durch Explosionen von Dampf oder Wasserstoff ist nach Meinung von Fachleuten im Fall einer Kernschmelze bisher nicht auszuschließen. Die Menge möglicher »Verkettungen unglücklicher Umstände« – von unvorhergesehenen technischen Pannen über den durch Bedienungsfehler bedingten gleichzeitigen Ausfall angeblich unabhängiger Sicherheitssysteme bis zum böswilligen Eingriff militanter Terroristen –, diese Menge von Möglichkeiten ist grundsätzlich nicht hinreichend übersehbar. Jeder Störfall kann eine neue Offenbarung bescheren. Wieder etwas gelernt – aber nichts über den nächsten.

Glauben Bürger und Politiker noch immer den wahrscheinlichkeitstheoretischen Beschwörungsformeln der Verkäufer? Nein, diese glauben selbst kaum noch, daß es auf Dauer gutgehen wird. Vielleicht werden schon Wetten abgeschlossen, welche europäische Großstadt oder Landschaft als erste auf lange Sicht unbewohnbar wird. Zwar kam Mütterchen Kiew nur durch die Hitze des Graphitbrandes im Tschernobyl-Reaktor und durch die Gunst des Wetters, das für die Verteilung über ganz Europa sorgte, gerade noch davon. Zwar hatten viele weißrussische Städte und Dörfer weniger Glück und müßten bei uns für unbewohnbar erklärt werden (obwohl auch dort letztlich weniger Menschen an Radioaktivität sterben oder leiden werden, als an unserem ein halbes Jahrhundert zurückliegenden Versuch, uns diese Gegend einzuverleiben). Aber all das läßt sich aus der Vogelperspektive durchaus in Kauf nehmen. Es geht allein ums verantwortungsvolle Abwägen von Chancen und Risiken.

Die Europäische Kommission hat in den letzten zehn Jahren führende Wissenschaftler daran arbeiten lassen. Ein schönes Ergebnis ist beispielsweise der Bericht (7) der »Ständigen Konferenz zum Thema Gesundheit und Sicherheit im Atomzeitalter«, die zum Zwecke der Akzeptanzförderung europäische Medienvertreter mit Fachleuten von EURATOM nach Luxemburg einlädt. Dort wurde unter anderem vorgerechnet, wieviel Strontium 90 nach einer Katastrophe in einem westeuropäischen Reaktor etwa im Brot zugelassen werden sollte, damit der finanzielle Verlust durch Zusammenbruch des europäischen Getreidemarktes nicht den Wert der Kinder und Erwachsenen übersteigt, die durch das Essen von Brot wahrscheinlich an Krebs sterben. Das ist echtes, wissenschaftlich begründetes Abwägen zwischen der Anzahl von Toten (die noch nach Qualität zu gewichten wären) und den volkswirtschaftlichen Schäden durch zu niedrige Grenzwerte. Man sieht: Ist das Restrisiko des schweren Unfalls erst einmal sozial akzeptiert, so wird es zum ganz normalen Risiko, mit dem man endlich wieder rechnen darf! Auch der weitere Ausbau der Kernenergienutzung ist so wieder voll verantwortbar, wie die Bundesregierung zum zehnten Tschernobyl-Gedenktag verlauten ließ. Niemand mehr muß sich deshalb Gewissenlosigkeit vorwerfen lassen.

Nur Mut! Verlieren wir nicht den Maßstab! Selbst wenn hie und da, dann und wann, eine Großstadt aufgegeben oder ein Landstrich verlassen werden und brachliegen müßte, so wäre das beim Abwägen gegen die Vorteile einer gesicherten Energieversorgung durchaus akzeptabel. Hand aufs Herz: Selbst der schwerste Unfall wäre doch das Problem einer Minderheit. Es war schon immer so, daß einige für das Glück anderer leiden mußten. Arbeitsteilung ist nun einmal das Grundprinzip unserer erfolgreichen Gesellschaft. Wir werden schon Glück haben und zur glücklichen Mehrheit gehören.

Einen wichtigen Punkt allerdings sollte man im Zusammenhang mit der Akzeptanzförderung nicht außer Acht lassen: Wegen des bekannten »Kindchenschemas« und verwandter Mitleidseffekte sollte man nach Kräften dafür sorgen, daß die Minderheit nicht identifizierbar ist. Es empfehlen sich daher technische Maßnahmen, die mithelfen, beim nächsten Unfall die Radioaktivität sogar noch weiträumiger und gleichmäßiger zu verteilen, als dies in Tschernobyl gelang. Hilfreich sind hierzu die Gedanken des britischen Wissenschaftlers Bernard Sansom, die er (nicht etwa in satirischer Absicht, wie ich erst glaubte) in der Zeitschrift New Scientist vorstellte (8): Eine statistisch nicht signifikante Zahl von Opfern sei nach den Regeln der Wissenschaft eigentlich als nicht existent anzusehen. Konkret: Wenn unter den an Krebs sterbenden Deutschen, gleichmäßig verteilt, jährlich zusätzlich tausend durch Tschernobyl oder ein ähnliches Unglück zugrunde gingen, wäre dies wissenschaftlich gesehen gar kein existierendes Ereignis! Logisch: Was ich nicht weiß, macht mich nicht heiß.

Nach diesem Kriterium ergibt sich ganz praktisch und vernünftig: Wir könnten uns vielleicht sogar im eigenen Land jedes Jahr einen Unfall à la Tschernobyl leisten, wenn wir nur alle Reaktoren schon beim Bau mit angemessenen Sprengladungen und gewaltigen Scheiterhaufen ausrüsteten, die im Falle radioaktiver Freisetzungen bei einem schweren Unfall sofort automatisch gezündet und entflammt werden müßten. Dann wäre dafür gesorgt, daß alle Schadstoffe sogleich in große Höhen transportiert würden und sich vor dem Niedersinken oder Ausregnen möglichst weltweit verteilen könnten. Vom erkenntnistheoretischen Standpunkt aus könnte es also die falsche Sicherheitsphilosophie sein, wegen des Restrisikos auf besseres Containment zu setzen. Nein, der bei unseren Reaktoren übliche Sicherheitsbehälter vergrößert womöglich das Risiko eines statistischen oder gar individuellen Nachweises von Unfallfolgen! Ein faszinierender Gedanke.

Denken Sie nur: Die Welt unserer Urenkel aus der Vogelperspektive: Zehn Milliarden Menschen, mit zehntausend Atomkraftwerken (erzwungenermaßen überwiegend Schnellen Brütern!) und den stillgelegten dazu, und den Wiederaufbereitungsanlagen, und den Endlagern, und all dem Herumkarren von Brennelementen und Plutonium und Atommüll. Und dennoch: Sorgfältige globale Gleichverteilung der Folgen unvermeidbarer Unfälle könnte dafür sorgen, daß keinerlei Schäden statistisch signifikant nachweisbar wären, denn auch Zehntausende zusätzliche Tote pro Jahr gehen in der Gesamtzahl der ohnehin Gestorbenen unter. Praktische Vernunft hätte so nicht nur das Restrisiko abgeschafft, sondern sogar das gewöhnliche Risiko großer Unfälle!

Diskontierung der Zukunft

Nun könnten freilich bei massivem, weltweitem Ausbau der Kernenergie doch irgendwann einmal noch größere Opferzahlen auftreten, die selbst mit optimalen statistischen Methoden nicht zu verbergen wären. Mit so etwas ist zu rechnen. Und auch infolge ganz anderer fortschrittlicher Aktivitäten, wie etwa chemischer und biologischer Techniken, stehen uns wohl noch eindrucksvolle Schadensereignisse bevor – ganz zu schweigen von den ohne große Einzelereignisse allmählich immer deutlicher werdenden Untergangssymptomen in Luft, Böden und Gewässern, in der ganzen Biosphäre, ja sogar beim Klima und den klimabedingten Meeresströmungen. Was da alles auf uns zukommen könnte, beunruhigt ja auch bereits zutiefst die Versicherungswirtschaft. Wir müssen deshalb noch kurz auf die Frage zurückkommen, wie wir Schäden bewerten sollen, die in fernerer Zukunft auftreten. Diese Bewertung ist unerläßlich, wenn wir solche Schäden gegen heutige Vorteile abwägen müssen. Glücklicherweise hat die Wissenschaft (zu der sich auch die Volkswirtschaft zählt) hierauf eine jedermann unmittelbar einleuchtende Antwort gefunden: Wenn ich weiß, daß ich in hundert Jahren Reparaturkosten von einer Million Mark zu zahlen haben werde, so muß ich mich nur fragen: Wieviel Geld muß ich heute zurücklegen, um dann die Schadenssumme begleichen zu können? Die zurückgelegte Summe wird bis dahin um Zins und Zinseszins anwachsen. Bei fünf Prozent Zinssatz wächst sie in hundert Jahren aufs 132fache, bei zehn Prozent aufs 13781fache, und bei 15 Prozent aufs 1174314fache. Man sieht sofort, daß es nicht angemessen wäre, für die Bewertung künftiger Schäden den mickrigen Zinssatz der Sparkassen, den Diskontsatz der Bundesbank oder gar die viel zu niedrige Rate des allgemeinen Wirtschaftswachstums anzusetzen. In der Tat benutzen Fachleute für solche Betrachtungen im allgemeinen eher den Zinssatz für Risikokapital. Nehmen wir doch ruhig einmal die 15 Prozent. Dann müssen wir für den Millionenschaden in hundert Jahren heute nur 85 Pfennig ansetzen!

Man bezeichnet diese plausible Methode der Bewertung künftiger Schäden als Diskontierung. An ihrem Erfolg erweist sich, fast noch eindrucksvoller als am phantastischen Wachstum der Geldvermögen, die wundertätige Macht des Zinses.

Dieses Prinzip ist für künftige Schäden aller Art anwendbar. Es ist eine der entscheidenden rechnerischen Hilfen des Künstlichen Gewissens. Ohne die Diskontierung der Zukunft könnten wir uns fast nichts von dem mehr leisten, was wir heute tun. Nun sehen wir aber zum Beispiel auch, warum man es sich um die letzte Jahrhundertwende, als Svante Arrhenius auf zu erwartende Folgen der atmosphärischen CO2-Anreicherung hinwies, leisten konnte, Warnungen in den Wind zu schlagen und die Verbrennungsprodukte eines weiteren Jahrhunderts in den Wind zu blasen. Wir verstehen auch, daß keinerlei »Gewissenlosigkeit« dazu gehörte, Millionen von Tonnen neuartiger Chemikalien und neuerdings sogar Lebewesen freizusetzen, die nicht mit der irdischen Biosphäre zusammenpassen. Schließlich konnte niemand ahnen, daß die Menschen so leichtsinnig sein würden, ständig das Geld abzuwerten, so daß unsere Rücklagen heute noch immer nicht ganz reichen, um das Klimaproblem zu lösen, die Ozonschicht zu reparieren und die ausgestorbenen Arten durch bessere und vor allem besser zusammenpassende zu ersetzen...

Verantwortung – was ist das eigentlich?

Warum komme ich nicht von diesem Sarkasmus los? Will ich Salz in die Wunden streuen? Ist denn unsere Lage nicht schmerzhaft genug, ja geradezu verzweifelt? Nein, ich bin voller Hoffnung und wollte Sie nur ein wenig necken! Sarkasmus hat seinen Sinn, wenn andere Möglichkeiten erreichbar sind: Die Neckerei soll an lebensunfähig gewordenen Denkgewohnheiten nagen, damit diese zusammenbrechen, bevor das Leben unter ihnen zusammenbricht. Nur wenn es keine Auswege gäbe, wäre Sarkasmus grausam. So aber ist er ein Aufruf zum Optimismus, Wenn es nämlich gelingt, den Zusammenbruch der falschen Ideen im Kopf zu bewirken, statt ihn in Biosphäre und Gesellschaft geschehen zu lassen, dann werden erreichbare lebensfähigere Möglichkeiten in Sicht kommen – und plötzlich wird es wieder für alle etwas Sinnvolles zu tun geben!

Um dies zu erkennen, müssen wir auch noch die Vogelperspektive hinter uns lassen. Schauen wir die Sache aus noch größerem Abstand an – sub specie aeternitatis, gewissermaßen. Wie wir mit Chancen und Risiken umgehen müssen, wie sich Verantwortung wahrnehmen läßt, das können wir nicht von Verfassungsrichtern lernen. Diese müssen uns selbstverständlich bestätigen, daß »nach den Regeln der praktischen Vernunft« eine Minderheit von Ängstlicheren oder Klügeren ein »Restrisiko« in Kauf zu nehmen habe, wenn die Mehrheit das Spiel wagen will. Wie sonst könnte die juristische Entscheidung aussehen? Schließlich können nicht Richter darüber urteilen, was Vernunft ist. Sie müssen voraussetzen, daß die aufgeklärte Gesellschaft dies in jahrhundertelanger Praxis herausgefunden hat! Jedes Recht braucht eine ethische Grundlage, aber das Wort Ethos bedeutet nichts anderes als Gewohnheit. In der Verfassung ist geronnen, was sich bewährt hat. Auch der selbstverursachte Weltuntergang wäre also verfassungsgemäß, denn bis zu diesem wäre es ja gutgegangen. So einfach ist es: Bis an den Rand des Abgrunds haben sich die verfassungsmäßigen Regeln der Jagd zum Abgrund bewährt. Erst jetzt kann allen klar werden, daß Zweifel an der Verfassung geboten sind.

Treiben wir die Aufklärung ein bißchen weiter. Es lohnt sich, die Spielregeln der Evolution anzuschauen. Beim langwierigen Tasten zwischen Chancen und Risiken hat die Wirklichkeit seit dem Anfang der Welt im Raum der Möglichkeiten Gestalten gefunden, die immer wieder durchlaufen werden konnten, die sich also am Abend eines Schöpfungstages als »sehr gut« bewährt hatten. Wurden »am nächsten Tag« noch höhere Gestalten gefunden, so geschah dies nicht etwa durch Verlassen bewährter Attraktoren, sondern vielmehr dadurch, daß im evolutionären Weitertasten raffiniertere Verflechtungsmöglichkeiten zwischen diesen entdeckt und erprobt wurden – bis sich am nächsten Abend wiederum zeigte, daß auch auf dem höheren Komplexitätsniveau »alles sehr gut« war. Diese Bewertung geschah freilich nicht etwa durch Abwägen, sondern allein durch den Erfolg, eben die Bewährung. Beim Hinschauen zeigt sich ja, wie wunderbar durch das lange Probieren schließlich alles zusammenpaßt, so daß immer wieder dieselben attraktiven Gestalten durchlaufen werden können. Die unvermeidbaren, letztlich zufälligen, kleinen Abweichungen bewirken einerseits noch bessere gegenseitige Anpassung, andererseits machen sie in vielfältigen Versuchen die Entdeckung noch höherer Komplexität mit noch schwächeren Wechselwirkungen wahrscheinlich. So findet die Wirklichkeit »ganz von selbst« einen Weg – immer höher hinauf in den Raum der Möglichkeiten, das Reich der Ideen, die geistige Welt oder wie immer wir diesen »Himmel« nennen wollen.

Wie wunderbar, dieses Schöpfungsprinzip! Und doch, wie unglaublich einfach! Die Sache kann insgesamt eigentlich nicht schiefgehen, möchte man meinen, wenn man die Geschichte anschaut, nicht wahr? Oder gibt es da etwa ein Restrisiko? Ja – die Geschichte ist nämlich nicht zu Ende. Beim Übergang vom sechsten zum siebten Tag wird eine unvermeidbare Krise erreicht, die systemtheoretisch gesehen schon durchs Prinzip des evolutionären Schöpfungsprozesses definiert ist. Ich nenne sie die »globale Beschleunigungskrise«. Ihr Wesen ist leicht zu verstehen: Höhere Innovationsgeschwindigkeit und größere Organisationsform haben einen selektiven Vorteil. Deshalb wird der Fortschritt immer schneller und zunehmend weltweit vereinheitlicht. Für beide Prozesse gibt es aber aus rein logischen Gründen kritische Grenzen. Räumlich ist das klar, weil die Erde endlich ist und die Sterne viel zu weit weg. Globaler als global kann die Organisation nicht werden. Aber auch die kritische Innovationsgeschwindigkeit ist leicht zu entdecken: Wenn die Anführer des Schöpfungsprozesses so schnell geworden sind, daß sie wesentliche Züge des Ganzen und ihrer selbst ändern können, bevor sie sich selbst bewährt haben, dann kann es nicht mehr »aufwärts« gehen. Immer unwahrscheinlicher wird es, daß Neues und Altes zusammenpassen. Die bis dahin im evolutionären Schöpfungsprozeß erreichte Komplexität wird abgebaut.

Natürlich paßt dann auch der Mensch nicht in seine neue Schöpfung. So viel ungewohntes Neues am eigenen Leibe zu spüren und die sozialen Folgen im eigenen Umfeld wahrnehmen zu müssen – das muß Angst auslösen. Wohin aber soll man nun fliehen? Die Angst, der alte nützliche Instinkt, wird in den Dienst der fortentwickelten Kreativität gestellt. Die Flucht nach vorn, zum achten Schöpfungstag, setzt ein. Das kollektive Fluchtverhalten wird mit Hilfe höchster Bewußtseinsleistungen immer raffinierter gesellschaftlich organisiert. Die Organisationsstrukturen wachsen bis zur globalen Skala an und verdrängen so die Versuche im Kleinen. Das ermöglicht weitere Steigerung des Tempos beim gemeinsamen Davonlaufen. Wie nennt man dieses Fluchtphänomen doch gleich? Ach ja – Fortschritt! ... Nur schnell fort von hier!

Wie dumm, daß dabei die Fehler wahrscheinlich immer größer werden und sich immer schneller global ausbreiten müssen. Das verträgt sich nicht mit den logischen Voraussetzungen, unter denen früher, mit unermeßlich vielen kleinen Fehlern, ganz allmählich evolutionärer Aufstieg gelingen konnte, ja mußte: Es fehlt an Vielfalt der Versuche und an Gemächlichkeit, um auszuprobieren, ob wohl Neues und Altes zusammenpassen und ein lebensfähiges Ganzes ergeben. Der Aufstieg muß deshalb wahrscheinlich, ja praktisch zwangsläufig, in Abstieg übergehen. Gemessen an den höchsten Gestalten, die im Laufe des evolutionären Schöpfungsprozesses im Raum der Möglichkeiten bisher erreicht wurden, das heißt gemessen an unseren eigenen seelisch-geistigen Fähigkeiten, kann also die Raserei wahrscheinlich nicht »aufwärts« führen. Die Krone der Schöpfung wird zum »Durcheinanderwerfer«. Das ist die Übersetzung des griechischen diabolos. Immer schneller kommen wir vorwärts und nähern uns endlich dem freien Fall – eben weil der Weg nach bestem Wissen und Gewissen mit so vielen guten Vorsätzen gepflastert ist.

Man kann vorm Teufel nicht davonrennen. Seine Eile ist unübertrefflich. Und doch läßt er sich besiegen! Die Einsicht in die systemtheoretischen Ursachen der globalen Beschleunigungskrise läßt uns den Weg dahin erkennen – und siehe da: Wir wußten es eigentlich schon lange, denn seit Menschen denken, haben sie dies im Ringen mit dem Problem der Verantwortung gelernt. Deshalb berichten alle Mythen der Menschheit davon.

Der Mensch ist wegen der Fähigkeiten, die am sechsten Tag gefunden wurden, eben nicht nur für das verantwortlich, was er ausrechnen kann, sondern vor allem für das, was er nicht einmal ahnen kann. Wenn er die Verantwortung fürs Ungeahnte abweist, ist er wirklich gewissenlos! Das hört sich absurd an, ist aber ganz einfach: Die menschliche Gesellschaft muß eine Verfassung finden, in der ungeahnte, schnelle, globale Entwicklungen an den Wurzeln – an den Erfolgen der ersten sechs Schöpfungstage – so unwahrscheinlich werden, daß man sie wirklich guten Gewissens als praktisch unmöglich betrachten darf. Was dafür zu tun wäre, kann ich hier nicht auch noch erzählen. (9)

Die Tabelle erinnert uns aber auch an einen anderen wichtigen Unterschied: Die in den letzten drei Zeilen angeführten Risiken (wie auch die Risiken vieler anderer neuer Techniken) sind von anderer Art als die weiter oben genannten. Sie lassen sich nicht durch Abzählen wirklicher Ereignisse bestimmen. Entweder weil viele verschiedene Ursachen ähnliche Phänomene hervorbringen (wie beim Krebs, wo eine Zuordnung immerhin ansatzweise durch umfangreiche epidemiologische Untersuchungen möglich wäre), oder weil die Ereignisse zwar folgenreich, aber doch sehr selten sind (wie Reaktorkatastrophen), oder weil viele unabsehbare Folgen erst nach Jahrzehnten sichtbar werden (wie bei der Anreicherung von Spurengasen in der Atmosphäre und von Giften in Böden und Gewässern), oder weil die Anwendung der entsprechenden Technik gerade erst begonnen hat (wie bei der Gentechnik). Die Wahrscheinlichkeit von Schäden ist dann zunächst völlig unbekannt.

Das ist in einem Rechtsstaat untragbar. Hier muß jedes Handeln justitiabel sein! Wie sollen denn die Behörden Anlagen und Verfahren genehmigen, und wie sollen Richter diese Genehmigungen beim Widerspruch einzelner Betroffener oder Fortschrittsfeinde beurteilen können, wenn die möglichen Folgen völlig unbekannt sind? Genehmigen will und muß man doch schließlich – sonst würde sich das Kapital einfach einen anderen Standort für jene Aktivitäten suchen – und dann wohl bald auch für alle anderen! Damit aber wären nicht nur Leben oder Gesundheit einer Minderheit bedroht, sondern es wäre bekanntlich uns allen jede Lebensgrundlage entzogen! Der Staat muß also die Wissenschaft dazu bringen, Fragezeichen durch Zahlen zu ersetzen, die in Gesetze, Verordnungen und richterliche Urteile eingehen können.

Im wesentlichen gilt noch immer der Grundsatz: Man darf alles tun, solange konkrete schädliche Folgen nicht wissenschaftlich nachgewiesen oder wenigstens aufgrund wissenschaftlicher Argumente höchst wahrscheinlich zu erwarten sind. Nun sind aber durch den wissenschaftlichen Fortschritt die Meßmethoden für Schadstoffe wie für Schäden immer empfindlicher geworden, und obendrein sind natürlich durch den Fortschritt der Zeit selbst immer mehr Risiken, die einem pro Jahr vernachlässigbar erscheinen mochten, manifest geworden. Wer stündlich eine neue chemische Verbindung herstellt, die es vorher auf der Erde oder gar im Universum nicht gab, der ist zunächst stolz auf seine Schöpferkraft. Hat man das freilich hundert Jahre lang getan und immer mehr von diesen Innovationen in wachsenden Mengen freigesetzt, dann zeigen sich allmählich Probleme – zum Beispiel, daß etwa stündlich eine lebendige Art ausstirbt, die zu ihrer Entstehung Jahrmillionen brauchte. (Inzwischen mögen es nach Aussage führender konservativer Biologen sogar schon eher zehn Arten pro Stunde sein...)

Nun geht es also offensichtlich darum, daß die Wissenschaft mögliche Schäden einer technischen Innovation rechtzeitig abschätzt. Auf dieser Basis sollen dann die Genehmigungsbehörden über neue Projekte entscheiden. Leider liegt es aber im Wesen komplexer Fragen, daß sich in ihnen auch Wissenschaftler nicht leicht einigen – und schon gar nicht in Eile. Wenn sie nicht so eng zusammenarbeiten, daß ihre Vorurteile und Fehler identisch werden, werden sie bei der Abschätzung eines Risikos im allgemeinen lauter verschiedene Zahlen finden. Das hat freilich auch seinen Vorteil: Nun weiß man, wer die kleineren Zahlen findet! Und damit liegt nahe, was zu tun ist, um ein Projekt genehmigungsfähig zu machen: Man muß Kommissionen aus jenen Wissenschaftlern berufen, bei denen die Zahlen klein genug herauskamen!

Da die anderen Wissenschaftler, jene mit den zu großen Zahlen, nicht in der Kommission sind, also auch weniger Geld verdienen, gelten sie fortan in der Öffentlichkeit und schließlich sogar unter Kollegen als die schlechteren Wissenschaftler und als weniger glaubwürdig. Obendrein kann das viele Geld, das hinter den Projekten steckt, auch durch Förderung von »Öffentlichkeitsarbeit« ein wenig nachhelfen, daß sie als defätistische Fortschrittsfeinde oder senile Pessimisten erkennbar werden. Daß sie nichts wissenschaftlich Haltbares zu sagen haben, wird endgültig klar, wenn die nationalen Kommissionen aus den Leuten, die kleinere Zahlen produzieren, sich in einer noch höher bezahlten internationalen Kommission vereinigt haben, die nun mit dem definitionsgemäß höchsten Sachverstand die Risiken quantifiziert und entsprechende Grenzwertempfehlungen gibt. Spätestens dann ist der auf dem Verordnungsweg gewonnene »Stand der Wissenschaft« gesichert...

Damit kein Mißverständnis aufkommt: In diesem Verfahren kann alles mit bestem Willen geschehen. Korruption mag zwar oft naheliegen, ist aber fürs Funktionieren keineswegs notwendig. Es genügt der gesellschaftlich organisierte Wille zu schnellerer Innovation und mehr globaler Vereinheitlichung. Diese Ideologie ist es, die die projektfördernde theoretische Vereinfachung komplexer Sachverhalte erzwingt. Hat sich erst einmal eine Gruppe normalbegabter Wissenschaftler zu diesem Zweck zusammengefunden und wird dafür zusätzlich gefördert, dann kommt es auch ohne jede Beteiligung von »Bosheit« leicht zum absurdesten, geradezu »kriminell« wirkenden Verhalten. Die Geschichte ist voll von Beispielen. Auf einige werden wir zurückkommen, doch wollen wir zuvor einigen Fragen, die immer wieder auftauchen müssen, etwas grundsätzlicher nachgehen.

Probabilistische Risikoanalyse – Beispiel Kernenergie

Bei genauerer Betrachtung wäre der Risikobegriff so komplex wie das Leben. Nehmen wir das Beispiel »Risiken der Kernenergienutzung«. Welche vorstellbaren Schäden soll man überhaupt zu bewerten versuchen? Was soll man zählen? Die unmittelbaren menschlichen Todesfälle? (»Beim Unfall in Tschernobyl gab es 31 Tote.«) Oder die verlorenen Lebensjahre, wenn der Tod nicht sofort, sondern erst später eintritt? (Dann sind es durch Tschernobyl vermutlich Millionen von Lebens-Jahren.) Oder die durch Gesundheitsschäden an »Lebensqualität« ärmer gewordenen Lebensjahre? Dann genügte ja das Zählen nicht, und man müßte auch noch gewichten! Und was ist mit den Erbschäden bei den Nachkommen? Mit den Schäden an der Pflanzen- und Tierwelt? Mit etwaigen Einflüssen aufs Klima? Was soll man da zählen oder wiegen? Und wie sollte man es zum Beispiel werten, wenn beim weiteren Übergang zur Atomenergienutzung zum Zwecke der Risikoverminderung die Macht von Verwaltung und Polizei wachsen müßte, wenn etwa aus Sicherheitsgründen, oder wegen der Proliferationsgefahr, eine Art dauernden Ausnahmezustands entstünde? Wäre das nicht vielleicht sogar positiv zu bewerten, gehörte also eigentlich auf die Waagschale der Chancen, weil es Arbeitsplätze im gehobenen Dienstleistungssektor schüfe, während ja solare Energietechniken nur Arbeit in simpler Produktion und Wartung und im Reparaturgewerbe brächten? Und schließlich die scheinbar noch schwierigere Frage: Wie soll man denn gesellschaftliche und biosphärische Folgen bewerten, wenn sie erst in fernerer Zukunft zu erwarten sind?

Für eine wissenschaftliche Risikodefinition sind solche Gesichtspunkte natürlich ungeeignet. Hohe Komplexität eines Systems bedeutet geradezu definitionsgemäß, daß das Wesentliche nicht wissenschaftlicher Analyse zugänglich ist. Wissenschaft beginnt zwangsläufig mit der Reduktion auf hinreichend Simples. Meist reduziert sie das vielfältige Risiko für Natur und Gesellschaft auf die Frage in der obigen Tabelle: Wie wahrscheinlich ist es, daß Menschen durch Freisetzung von Radioaktivität aus einer bestimmten kerntechnischen Anlage getötet werden? Schon die Frage nach Krankheiten, die nicht zum Tode führen, würde ein so weites Feld eröffnen, daß man sie meist gar nicht erst stellen mag.

Um wenigstens auf die einfachste Frage eine Antwort zu finden, muß man abschätzen, wieviel Aktivität freigesetzt werden wird – im angestrebten »Normalbetrieb«, wie auch bei allen zu erwartenden Zwischenfällen. Um den letzteren überhaupt Zahlen zuordnen zu können, hat man die sogenannte »probabilistische Risikoanalyse« entwickelt: Da die Ereignisse, die man zählen müßte, in der bisherigen Praxis nur selten oder noch gar nicht stattgefunden haben, versucht man auf dem Papier alle möglichen Ereignisketten zu konstruieren, die zu ihnen führen könnten. Dann versucht man, jedem Glied jeder solchen Kette eine Wahrscheinlichkeit zuzuordnen – entweder aufgrund von Erfahrungen mit verwandten Bauteilen und Abläufen in anderen Anlagen oder notfalls durch Spekulation. (Beispiele: Platzen eines Kessels? Versagen einer Dichtung oder eines Ventils? Ausfall eines Meßinstruments? Fehlerhafte Bedienung eines Schalters?) Nun muß man untersuchen, wie weit die betrachteten Glied-Ereignisse voneinander unabhängig sind – dann kann man die Gesamtwahrscheinlichkeit jeder Kette ausrechnen und schließlich die Wahrscheinlichkeiten aller Ketten addieren. Mit diesem Verfahren kam man zum Beispiel zu der Aussage, ein Kernschmelzen in einem deutschen Reaktorkern sei höchstens einmal in zehntausend Betriebsjahren zu erwarten. (4)

Weiter geht‘s dann mit Betrachtungen zum optimalen »Unfallmanagement«: Wie kann durch Konstruktionsmerkmale (etwa die »Wallmann-Ventile« zur gezielten »Druckentlastung« im Falle drohender Explosion) und durch Verhaltensregeln fürs Personal dafür gesorgt werden, daß mittels kontrollierter Freisetzung von Radioaktivität eine eventuell noch katastrophalere Freisetzung unwahrscheinlicher gemacht wird? Über solche Verfahren einer neuen »nuklearen Sicherheitskultur« wird öffentlich erst seit einer Konferenz (November 1988 in München) gesprochen, auf der die weltweite Nuclear Community gemeinsame Sicherheitsstandards zu formulieren versuchte. Ein Zitat von dort: »Dem Streben nach Akzeptanz für die Kernenergie ist es abträglich, wenn Unterschiede zwischen den Sicherheitsniveaus verschiedener Staaten existieren oder diskutiert werden.« (5) Bemerkenswert ist auch die seither herrschende Sprachregelung: Was ich hier noch »probabilistische Risikoanalyse« nenne, heißt in der nuklearen Gemeinschaft nun »probabilistische Sicherheitsanalyse« – abgekürzt nicht mehr PRA, sondern PSA. So leicht läßt sich »risk« durch »safety« ersetzen.

Die mit viel gutem Willen ermittelten Wahrscheinlichkeiten für bestimmte Typen von Unfallereignissen muß man nun als Ausgangspunkt für weitere hypothetische Ereignisketten nehmen: Welche Bruchteile des Inventars an verschiedenen Nukliden werden in Luft, Wasser und Boden freigesetzt? Wie verbreiten sie sich weiter? Wie werden sie von Lebewesen aufgenommen? Was gelangt direkt oder über die Nahrungskette in den Menschen? In welchen Organen wird es wie lange gespeichert? Wie wirkt sich das schließlich auf die Gesundheit und die Erbanlagen der Bewohner in verschiedenen Abständen vom Unfallort aus, und wie viele Todesfälle, Krankheiten und Erbschäden werden dadurch in verschiedenen Zeiträumen verursacht? Wenn berufene Kommissionen diese Fragen beantwortet haben (von Fragen nach anderen biosphärischen Folgen ganz zu schweigen), haben wir endlich eine der Zahlen, die ein Fragezeichen in der Tabelle ersetzen sollen! Gibt es Gründe, sie zu glauben?

Restrisiko